看到ChatGPT的华丽诞生,心情很复杂,既高兴、惊喜,也感到恐慌,高兴和惊喜的是没有预料到这么快就见证了自然语言处理(NLP)技术的重大突破,体验到通用技术的无限魅力。恐慌的是ChatGPT几乎可以高质量地完成NLP中的大多数任务,逐渐认识到很多NLP的研究方向遇到了极大挑战。总体而言,ChatGPT最令人非常惊艳的...

关于ChatGPT八个技术问题的猜想

分词数据集

分词数据集1. SIGHAN 2005数据集数据集简介:SIGHAN 2005数据集国际中文自动分词评测(简称SIGHAN评测)整合多个机构的分词数据集构成。该数据集由中国微软研究所、北京大学、香港城市大学、台湾中央研究院联合发布,用以进行中文分词模型的训练与评测。其中 AS 和 CityU 为繁体中文数据集,PKU ...

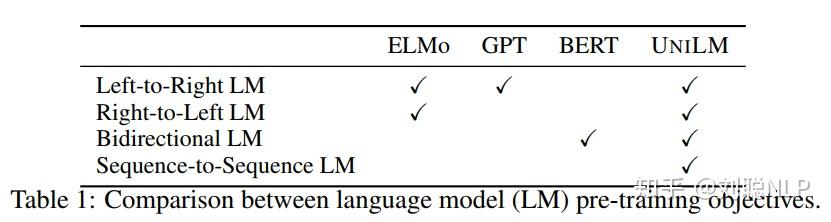

unilm

UniLM论文全名为Unified Language Model Pre-training for Natural Language Understanding and Generation,译为自然语言理解与生成的统一预训练语言模型,来自于微软研究院。论文地址:paper论文代码:code前一段时间一直再撸这篇论文的...

nn-sdk

Project descriptionnn-sdk是一个基于tensorflow(v1 ,v2)和onnx神经网络推理开发包nn-sdkhttps://pypi.org/project/nn-sdk/python demo# -*- coding: utf-8 -*-from nn_sdk import *config...

load and save tf weight

ckpt = tf.train.Checkpoint(model=encoder)ckpt.restore(checkpoint_from_path).expect_partial()tf1_var_dict = {}for weight in encoder.weights:var_name = weight.nam...

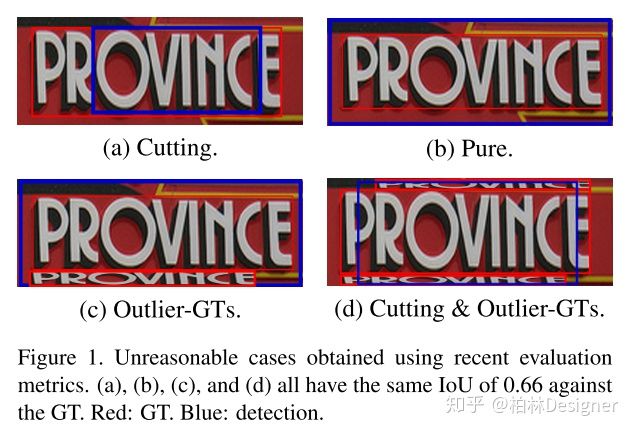

文本检测TIoU--metric

Tightness-aware Evaluation Protocol for Scene Text DetectionKeyWords Plus: CVPR2019 Curved Text metric 一种新的评价指标改进了以为评价指标的一些缺陷paper :PaperGithub: GithubIntroduct...

ckpt加载

import tensorflow as tffrom bert import modelingimport os# 这里是下载下来的bert配置文件bert_config = modeling.BertConfig.from_json_file("chinese_L-12_H-768_A-12/bert_config...

tf.estimator.Estimator类的用法

官网链接:https://www.tensorflow.org/api_docs/python/tf/estimator/Estimator Estimator - 一种可极大地简化机器学习编程的高阶 TensorFlow API。Estimator 会封装下列操作: 训练评估预测导出以供使用 您可以使用官方提供的预...

BERT代码剖析

BERT (Bidirectional Encoder Representations from Transformers) 官方代码库 包含了BERT的实现代码与使用BERT进行文本分类和问题回答两个demo。本文对官方代码库的结构进行整理和分析,并在此基础上介绍本地数据集使用 BERT 进行 finetune 的操...

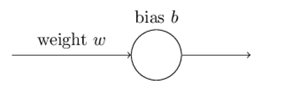

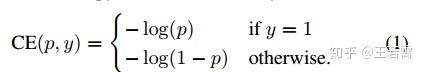

Cross-entropy

我们希望并期望我们的网络能够从他们的错误中学习的很快,首先看一个小例子。 我们将训练这个神经元做一些非常简单的事情:把输入的1转换成输出的0。当然,如果我们不是用学习算法,可以很容易地计算出一个适当的权重w和偏差b。但是我们为了说明一些问题,就使用梯度下降法来学习权重和偏差,这对于后面的学习很有启发性。让我们来看看神经...

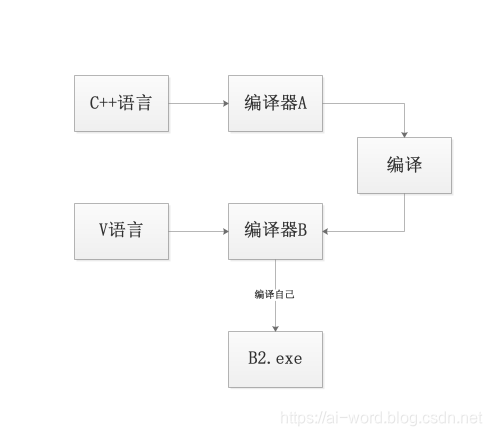

编程语言自举

1. 自举的含义自举(bootstrapping)字面理解就是自己能把自己给举起来,换做编程语言来讲就是,自己编译自己,可以看看(wiki上面的解释)(https://en.wikipedia.org/wiki/Bootstrapping_(compilers))那么语言自举过程到底是个怎么样的过程?下面选取了来自知乎...

Focal loss论文详解

Focal Loss for Dense Object DetectionICCV2017 RBG和Kaiming大神的新作。论文目标我们知道object detection的算法主要可以分为两大类:two-stage detector和one-stage detector。前者是指类似Faster RCNN,RFCN...

Focal Loss tensorflow 实现

def focal_loss(pred, y, alpha=0.25, gamma=2): r"""Compute focal loss for predictions. Multi-labels Focal loss formula: FL = -al...

机器学习——softmax计算

概念与应用Softmax是机器学习中一个非常重要的工具,他可以兼容 logistics 算法、可以独立作为机器学习的模型进行建模训练、还可以作为深度学习的激励函数。softmax的作用简单的说就计算一组数值中每个值的占比,公式一般性描述为:设一共有个用数值表示的分类,其中表示分类的个数。那么softmax计算公式为:。...

Pytorch常用的交叉熵损失函数CrossEntropyLoss()详解

引言 在使用pytorch深度学习框架,计算损失函数的时候经常会遇到这么一个函数:nn.CrossEntropyLoss() 该损失函数结合了nn.LogSoftmax()和nn.NLLLoss()两个函数。它在做分类(具体几类)训练的时候是非常有用的。在训练过程中,对于每个类分配权值,可选的参数权值应该是...

共22条记录

没mac版本。